AI倫理の今と未来。児童福祉×AIシステムの在り方

2023/12/23

急速にAI(人工知能)が発展する中、AIにまつわるプライバシーや公平性などの指針・基準を設けようという動きが国内外で強まっています。「AI倫理」にまつわる世界的な動向や児童福祉領域における課題、AiCANサービスの取り組みについて、当社のCEO・髙岡が語ります。

髙岡昂太/Kota Takaoka

教育学博士、臨床心理士、公認心理師、司法面接士。

児童相談所や医療機関、司法機関において、15年間、虐待や性暴力などに対する臨床に携わっている。

2011年千葉大学子どものこころの発達研究センター特任助教、学術振興会特別研究員PD、海外特別研究員(ブリティッシュコロンビア大学)を経て、2017年より産業技術総合研究所人工知能研究センター所属、主任研究員。2020年3月に株式会社AiCANを立ち上げ、2022年4月から同社CEOに就任。

AIへの過度な期待から倫理の重要性が高まる

――ChatGPTをはじめ、昨今話題の生成AIにおいては、情報漏洩や誤情報が出るリスクがよく報道されています。プライバシーや公平性、透明性や説明責任などの「倫理」の問題もありますが、AI倫理に関する世界的な動向を教えてください。

2023年10月にアメリカのバイデン政権は、AIについて安心・安全で信頼できる開発と利用をするための大統領令を発令しました。また、G7広島サミットでは、岸田首相から「広島AIプロセスの創設」の提案があり、信頼できるAIの実現のために不可欠な共通原則を策定することが決まりました。

これほど急速にAI倫理の議論が進んでいる背景には、急速なAIの進歩と人々の過度な期待があると思います。人間が適切にAIを使用するにあたって、倫理に関する議論は不可欠。きちんと統制・管理していかなくてはいけないという動きが強まっています。

児童福祉領域をはじめ、社会課題にまつわる分野では、特に倫理観や公平性、透明性が求められます。AIが計算して出したデータを人間が参照したとき、どこをどう活用するのか?という判断基準の整理が重要になるでしょう。こうした整理をしておかないと、AIの利活用によって人のバイアスを助長してしまい、新たな差別や弊害が生まれる可能性があります。

データの見方次第で差別を助長する危険性も

――児童福祉領域における人のバイアスの助長の危険性について、もう少し詳しく教えてください。

AIは「データが全て」というところがあるので、どういう項目のデータを集めるかが非常に重要です。その項目が差別を助長しないか、慎重に検討する必要があります。

例えば、年齢層や人種でグルーピングしたときに、特定のグループの児童虐待率が高いというデータは存在しますし、こうした項目をひとつの要素として確認することは大事です。しかし、その項目だけに注目することで、「〇〇の年齢層の人は虐待する」「〇〇の人種だから虐待する」といった思考にならないように注意しなくてはいけません。データが適切に使われているのか、差別的な解釈をしていないか。バイアス(偏見)を助長しないように慎重な検討が求められます。

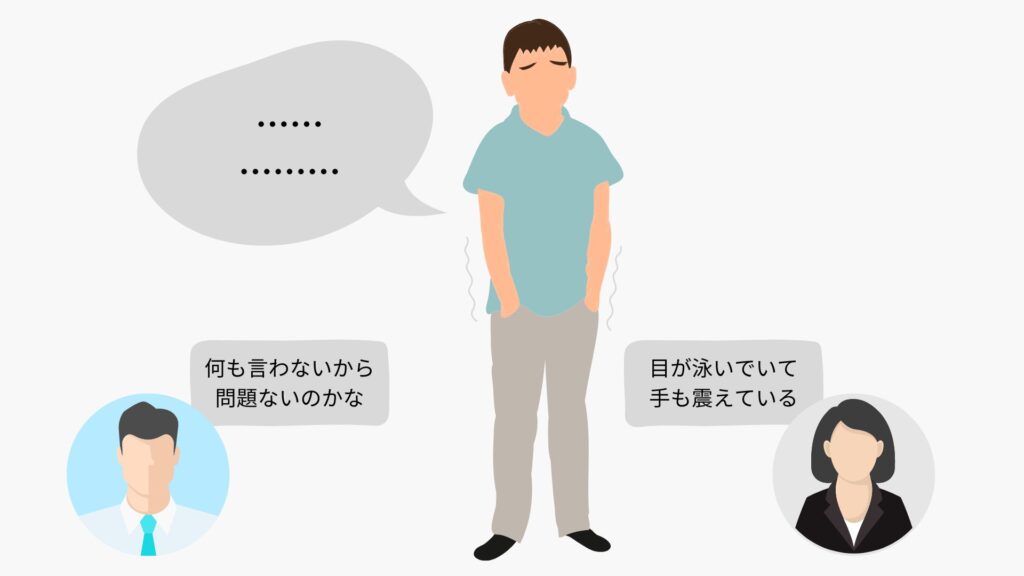

また、児童福祉はデータの集め方にも高い専門性が求められる分野です。例えば、子どもに話を聞く際、保護者から脅されている、幼いために言葉をうまくまとめられないといった事情から黙ってしまうことはよくあります。「集めたデータの信頼性をどのように保つのか」という問題も、倫理的な観点として生じるんです。

同じように「本当は怖いことがあったけれども言えない」子どもに接したとして、経験が長い方であれば「手が震えている」「目が泳いでいる」といった部分に注目して観察し、「本当のことが言えないのかも」と気付くことができる。でも、専門性や経験値が低いと、「話さないということは問題ないんだな」と捉えて見過ごす可能性があります。データの使い方や調査・収集の仕方に関するトレーニングが重要です。

丁寧な説明とモニタリング、世界的動向への対応

――AiCANでは、2022年から児童福祉分野での意思決定に関するAIの品質と安全性を管理するための体制整備をしていますが、具体的な内容を教えてください。

大きく分けて、3つの対応を行ってきました。順番にご紹介します。

(1)AIのメリットと限界に関する説明・合意形成

AIについて、自治体様から「魔法の杖のように何でもできる」「出てきたものをそのまま使える」といった誤解をされるケースもあるのですが、あくまで主体は人間の判断や対応であって、AIは人間に「寄り添う」ものです。利用いただく際にきちんとAIに関するご説明をして、メリットだけではなく限界点についてもご理解いただき、合意形成をしています。

もう少しわかりやすく言うと、人間が「本当にこれでいいのかな」と迷ったとき、AIは多面的な見方をしてくれて、バイアス補正をしてくれるような、「一人の同僚」のような存在なんです。ただし、AIはあくまで入力されたデータの中でしか判断できません。当然ながら、口頭でやりとりをしてデータ化されていないケースの要因は考慮できません。

データの質次第でAIが出す結果の精度も変わってしまうため、「AIが言っているから」と最終的な判断までAIに丸投げするのは危険です。AIが出力した内容を参考にしながら、あくまで人間が判断する必要があります。こういった部分を丁寧にお伝えしています。

また、各自治体の特性を反映したAiCANサービスを使うためには、以下のような段階的な導入が必要になることもお話ししています。

| 一段階目:AI使用の目的設定とデータ収集 まずはAIを何の課題を解くために参照したいのか、という課題設定を行います。児童虐待対応と一口に言っても、地域によって課題はさまざま。例えば都市部では、案件数が多くとても忙しいので、「より早く、見過ごしなく重篤な事例を把握したい」という目的設定をされるケースもあります。こうした課題設定に応じてデータを集めていきます。 二段階目:テスト いきなり本番運用することはリスクが高く、テストが必要です。使い勝手を確認し、どうすればより活用できるのかを検討・精緻化していくプロセスを設けます。 三段階目:本番リリース データを使っていただくための研修や、混乱が起きないように「よく聞かれる質問」などをまとめた後、サービスとしてリリースします。 |

(2)データの収集・使い方に関する慎重な検討とモニタリングができる体制

2点目は、倫理的な観点も含めて入力されるデータの集まり方がおかしくないか、出力された予測結果が人間の考えと大きくずれていないか、といった部分のモニタリングをする体制の構築です。

例えば、性的虐待が全虐待案件のうちの数%であることが続いていたのに、あるときを境に急に10~20%になったら、さすがに出現率がおかしい、という話になりますよね。入力欄を間違えている人がいたり、性的虐待の定義を間違えている人がいたりする可能性もあるでしょう。実際には、これまでに大きなトラブルが発生したということはありませんが、データに何か怪しい部分があった際には、利用の停止をするというフローにしています。

モニタリングに関しては科学的な厳しい観点を持って自社内でも検討していますが、第三者の視点も重要です。当社では意思決定AIの倫理基準について東大と共同研究契約をしており、その取り組みの中で倫理や公平性の観点からAiCANサービスを客観的に検討してもらっています。

(3)法律・条約の順守/国内外の情勢を踏まえた対応

AIのセキュリティ・倫理などに関する法律や条約、社会的情勢については、国内外に限らず情報を収集し、開発に活かしています。

現場の視点と社会科学的な視点を持ち寄って検討

――(2)の項目でお話のあった東大との共同研究について、取り組みを始めたきっかけ・想いや研究計画について、詳しく教えてください。

AiCANを作る以前、私は産業技術総合研究所に所属していたのですが、そこで東京大学の江間有沙准教授とお会いすることがありました。私は元々児童福祉の現場側にいた人間ですが、江間先生は社会科学的な視点からAI倫理を研究されており、世界でもトップクラスのオピニオンリーダーです。当時から、異なる立場からの視点を持ち寄り、意見交換をしてきました。

今回の共同研究契約は、当時と同様に互いの視点を活かしてよりよい研究をしたいという意図もありますし、さきほどお話したように、AiCANサービスのデータの透明性やモニタリングの仕方などを第三者に評価いただきたいという意図があります。

江間先生が関わっていらっしゃる社会課題解決、民主主義、法律などに関係するAIの利活用分野では、欧州評議会、アラン・チューリング研究所というような国際的に名だたる機関で検討されているフレームワークがあります。AiCANサービスのガイドラインやチェック体制が、その基準に照らし合わせて問題がないか、改善すべきところがないかを突き詰めていくことを目標に、議論を深めてきました。2023年度3月までに方向性を定めていく予定です。

ーーありがとうございました。次回は、具体的にどのように自治体を支援しているのか、詳しくご紹介します!

※本記事は、2023年10月時点の取材をもとに制作しています。

(取材・執筆 藤澤佳子)